Sánchez-Martín,

M.; Chacón-Moscoso, S. y Sanduvete-Chaves, S. (2015). Potenciar la calidad en

formación continua: una aplicación en el ámbito deportivo / Enhancing Quality

in Training Programs: An Application in the Sport Area. Revista Internacional de

Medicina y Ciencias de la Actividad Física y el Deporte vol. 15 (60) pp. 613-629. Http://cdeporte.rediris.es/revista/revista60/artpotenciar633.htm DOI: http://dx.doi.org/10.15366/rimcafd2015.60.001

Sánchez-Martín,

M.; Chacón-Moscoso, S. y Sanduvete-Chaves, S. (2015). Potenciar la calidad en

formación continua: una aplicación en el ámbito deportivo / Enhancing Quality

in Training Programs: An Application in the Sport Area. Revista Internacional de

Medicina y Ciencias de la Actividad Física y el Deporte vol. 15 (60) pp. 613-629. Http://cdeporte.rediris.es/revista/revista60/artpotenciar633.htm DOI: http://dx.doi.org/10.15366/rimcafd2015.60.001

ORIGINAL

POTENCIAR LA CALIDAD EN

FORMACIÓN CONTINUA: UNA APLICACIÓN EN EL ÁMBITO DEPORTIVO

ENHANCING QUALITY IN TRAINING PROGRAMS: AN APPLICATION IN THE SPORT AREA

Sánchez-Martín, M.1;

Chacón-Moscoso, S.2 y Sanduvete-Chaves, S.3

1 Profesora

Adjunta, Universidad Loyola Andalucía, España, msanchez@uloyola.es

2 Profesor Titular

de Universidad, Universidad de Sevilla, España; Universidad Autónoma de Chile,

Chile, schacon@us.es

3 Profesora

Contratada Doctora, Universidad de Sevilla, España, sussancha@us.es

AGRADECIMIENTOS O FINANCIACIÓN

El presente trabajo forma parte de los

resultados obtenidos en los proyectos de investigación SEJ2004-05360/EDUC,

P06-HUM-01458, PSI2011-29587 y 1150096 subvencionados por el Ministerio de

Educación y Ciencia, por la Consejería de Innovación, Ciencia y Empresa de

Los

autores agradecemos enormemente los comentarios recibidos por parte de

Christopher Thompson. Consideramos que el contenido de este trabajo ha sido

sustancialmente clarificado y mejorado como resultado.

UNESCO code/ Código Unesco: 6105.99 Evaluación de programas/

Program evaluation; 5311 Organización y dirección de empresas/ Organization and

Business Management.

Clasificación Consejo de Europa /

Council of Europe classification: 1. Administración organización y gestión del

deporte/ Administration organization and sport management.

Recibido 3 de

agosto de 2012 Received August 3, 2012

Aceptado 29 de

octubre de 2013 Accepted October 29, 2013

RESUMEN

En

el ámbito educativo, la gestión de la calidad suele llevarse a cabo mediante la

aplicación de modelos específicos para este ámbito o bien mediante modelos

estándares. Ambas alternativas tienen sus ventajas e inconvenientes; sin

embargo, la mayoría de las organizaciones educativas prefieren implantar

modelos estándares que suelen conllevar ciertos desajustes durante su

implementación. Para hacer frente a esta situación, en este trabajo se propone

un instrumento que, aplicado durante los procesos evaluativos de estas

organizaciones, facilita la especificación y mejora de la participación, la utilidad y

la transparencia, creando un contexto

que favorezca la aplicación exitosa de los modelos estándares de gestión. Se

describe su aplicación en la evaluación de necesidades llevada a cabo en el

Departamento de Formación Continua de una organización andaluza dedicada al

ámbito deportivo; se analizan los resultados mediante indicadores clave antes y

después de aplicar el instrumento; y se valoran las ventajas obtenidas.

PALABRAS

CLAVE: Educación,

formación continua, gestión de la calidad, deporte

ABSTRACT

In

the field of education, specific or standard models of quality management are

usually performed. Both alternatives have their advantages and disadvantages,

but most educational organizations prefer to implement standard models which

usually include some mismatches during their implementation. To address this

situation, we propose an instrument that, when applied during the evaluation

processes of these organizations, facilitates the specification and improvement

of participation, usefulness and transparency. This creates a context

that enhances the successful application of standard models. The instrument

implementation is described in the needs assessment process of the Training

Program Department in an Andalusian sports organization. Results are analyzed using

key indicators before and after applying the instrument. Finally, potential

advantages are discussed.

KEY WORDS: Education,

training program, quality management, sport

INTRODUCCIÓN

La

aplicación de un Modelo de Gestión de la Calidad (MGC) es uno de los objetivos prioritarios de la

mayoría de las organizaciones

que desean progresar. Esta temática comenzó a despuntar en el ámbito

industrial, pero hoy en día es un objetivo a lograr para cualquier tipo de

empresa. Según Abdi, Awan y

Bhatti (2008), un 85% de las empresas adoptan las normas ISO-9000 como MGC,

cuya implementación aumenta las ventas, las exportaciones, la rentabilidad así

como el bienestar tanto del propietario como de los trabajadores.

Las

organizaciones que en lugar de producir bienes se dedican a la educación vieron

en estos modelos una oportunidad de orientarse más a los mercados, a semejanza

de otros negocios (Liao, Chang y Wu, 2010a) y comenzaron a aplicar MGC sin

tener en cuenta que presentaban características específicas (Asif, Awan, Khan y

Ahmad, 2011). El ámbito educativo es multidimensional y complejo, puede ser

interpretado de diversas formas por diferentes implicados y sus resultados

pueden ser tangibles, intangibles o la adición de valor a través de, por

ejemplo, los resultados de los exámenes, el empleo, las ganancias o la

satisfacción (Becket y Brookes, 2008).

Precisamente

debido a las características que presenta el ámbito educativo, actualmente no

existe un consenso sobre cómo gestionar eficazmente la calidad, entendida desde

la perspectiva de la educación superior y centros de formación continua. Como

resultado de esta complejidad, se han adoptado fundamentalmente dos

aproximaciones para gestionar la calidad (Becket y Brookes, 2008): 1. Por una

parte, están los contenidos, criterios, directrices o modelos desarrollados

específicamente para la educación. Algunos ejemplos son los modelos de Regnier,

Kopelow, Lane y Alden (2005), el de Liao, Chang y Wu (2010b) o el estándar

ISO/IEC 19796-1 para el aprendizaje, educación y formación (Pawlowski, 2007).

Según Becket y Brookes (2008), la mayor aportación de este tipo de

aproximaciones es el reconocimiento de la importancia de la experiencia de

aprendizaje de los alumnos en las iniciativas de gestión de la calidad y, ya

que se han desarrollado específicamente para el ámbito educativo, se pretende

que sean más compatibles con el papel principal de la educación que los modelos

industriales. Sin embargo, salvo casos contados como el modelo de Srikanthan y

Dalrymple (2004), la mayoría se han elaborado tomando como referente los

modelos industriales. Además, estos enfoques parecen no estar teniendo mucha

aceptación en Europa (Ehlers,

Hildebrandt, Görtz y Pawlowski, 2005) y las empresas siguen prefiriendo aplicar

modelos estándares. 2. Por otra parte, se encuentran los modelos estándares de

gestión de la calidad como las normas ISO o el modelo EFQM. Estos modelos

tienen la ventaja de la adopción de un enfoque estratégico para la medición de

la calidad y la gestión, así como el compromiso en la auto-evaluación frente a

criterios predeterminados y la obtención de beneficios en las funciones de

administración y servicios. Sin embargo, para lograr esto, deben cumplirse unos

requisitos críticos durante su implementación, como son un alto nivel de

compromiso, la satisfacción del cliente y la delimitación de unos objetivos

estratégicos a medio o largo plazo. También son necesarios un liderazgo

efectivo y suficientes niveles de financiación y recursos humanos (Becket y

Brookes, 2008; Cruickshank, 2003).

Así,

a pesar de la gran aplicación que se

ha hecho y aún se sigue haciendo de los MGC en organizaciones educativas como

universidades o centros de formación continua (Becket y Brookes, 2008; Kasperavičiut, 2011; Sakthivel y Raju, 2006),

diversos estudios han comprobado la dificultad de su implementación en estos

contextos (Asif et al., 2011; Liao et al., 2010a; Pawlowski,

2007; Sirvanci,

2004). Se ha detectado en la literatura especializada varias limitaciones y

desajustes al aplicar estos modelos estándares en este tipo de organizaciones (Domínguez y Lozano,

2005), como la falta de proporcionalidad entre la inversión en esfuerzo y

tiempo con la mejora que se consigue; el mayor interés por la imagen de la

institución que por la calidad de la formación, entendida como la adecuación de

dicha formación a las necesidades reales de los demandantes; la dificultad de

aplicación directa de modelos estándares en organizaciones no relacionadas con

la producción de bienes (Pawlowski, 2007; Van den Berghe, 1998), debido

principalmente a la falta de especificación de los objetivos a cumplir, y a la

estructura vertical de comunicación entre los empleados (Boyer, 2003); así como

la necesidad de buscar alternativas que permitan evaluar aspectos como los

procesos, la transferencia o el impacto, ya que la calidad de la formación

suele evaluarse teniendo en cuenta básicamente criterios de resultado (Andrés,

2005; Aragón, 2004; Dickerson, 2000; Domínguez y Lozano, 2005).

Así

mismo, también se han observado otras dificultades relacionadas con la gestión

y liderazgo y con las estructuras burocráticas existentes que merman la

aplicación de los modelos. Además, se debate sobre el rol del alumno como

cliente o co-productor en el sistema y el impacto que esto tiene en la medición

y gestión de la calidad (Becket y

Brookes, 2008).

Un

agravante de esta situación viene dado por el contexto socio económico en el

que nos encontramos, ya que toda organización debe minimizar costes y más aún

aquellas que se financian total o parcialmente con fondos públicos, como es el

caso de buena parte de las universidades y centros de formación continua

(Martínez y Martínez, 2009). Es esencial que las organizaciones sigan apostando

por la calidad, pero desde la base de la eficiencia económica y teniendo en

cuenta las limitaciones de recursos existentes.

En

resumen podemos decir que, a pesar de las limitaciones comentadas al

implementar modelos estándares, muchas organizaciones han confiado en ellos,

bien aplicados directamente o adaptados para su uso en el ámbito educativo.

Así, surge la necesidad de desarrollar estrategias que faciliten la aplicación

exitosa de MGC consolidados, ya que estas limitaciones no implican que no tengan el

potencial de mejorar la calidad de las instituciones educativas y lograr la

mejora continua (Liao, Chang y Wu, 2010a).

La

principal contribución de este trabajo viene desde la metodología y consiste en

aportar un instrumento que, aplicado en los procesos evaluativos de las

organizaciones, potencie un contexto proclive para la aplicación eficaz de un

MGC. Este instrumento se estructura sobre tres referentes básicos de los MGC,

que enhebran el buen funcionamiento de un sistema: la participación, la utilidad

y la transparencia. Se plantea que la

especificación y mejora de estos referentes provocará un contexto facilitador para

la aplicación de un MGC en el ámbito que se aborda, minimizando los desajustes

comentados (Amo y Cousins, 2007). Tal y como decía Pawlowski (2007), el

apropiado cumplimiento de los objetivos y necesidades de las partes interesadas

(lo cual bien podría ser la satisfacción del usuario, uno de los objetivos

primordiales de las empresas para implantar un MGC y muy ligado a la calidad;

Calabuig, Burillo, Crespo, Mundina y Gallardo, 2010) es el resultado de una

negociación participativa y transparente dentro de una organización. He aquí la

importancia de estos constructos para propiciar un contexto que potencie y

mejore la calidad organizacional.

Así,

la participación se entiende como la concreción de las distintas

acciones a ejecutar por los implicados a lo largo de una intervención (Chacón,

Anguera, Pérez-Gil y Holgado, 2002; Feterman y Wandersman, 2007); la utilidad

como el uso instrumental de los resultados de la evaluación, como referente

para la toma de decisiones (Vedung, 1996; Weiss, 1979); y la transparencia

implicaría la disponibilidad y accesibilidad de la información sobre el proceso

para todo aquel interesado (Anguera, Chacón y Sánchez-Martín, 2008).

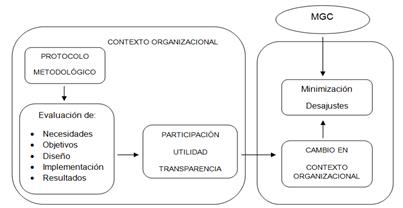

El

instrumento comentado es un protocolo metodológico, cuyo objetivo principal es

facilitar que se especifiquen todos los procesos de la organización y que, como

consecuencia, se puedan medir los indicadores de participación, utilidad y transparencia.

Así mismo, la medición de estos tres referentes posibilitará que posteriormente

puedan mejorarse y que se cree un contexto proclive para la implementación de

un MGC, minimizando los desajustes de su aplicación en organizaciones

educativas (ver Figura 1).

Figura 1. Esquema

de cómo el protocolo metodológico favorece un contexto que minimice los

desajustes al implementar un MGC.

En

este trabajo, la problemática comentada se focaliza en el ámbito de la

formación continua (Alemna, 2001), mediante la cual las organizaciones

pretenden responder y cubrir las necesidades de formación y adaptación de los

trabajadores, potenciando la mejora continua y la recualificación de las

personas; y, más específicamente, en cómo facilitar la implementación de MGC en

una organización del ámbito deportivo que imparte este tipo de formación.

De

forma concreta, los objetivos de este trabajo son: 1. Aportar un instrumento

para facilitar la aplicación de modelos estándares de calidad en contextos educativos;

y 2. Ilustrar, mediante buenas prácticas, la aplicación y potencialidad de esta

herramienta, en un proceso de evaluación de necesidades formativas (NNFF) en

una organización educativa del ámbito deportivo.

PROTOCOLO METODOLÓGICO PARA EL DISEÑO, IMPLEMENTACIÓN Y EVALUACIÓN DE

PROGRAMAS DE FORMACIÓN

En

|

Tabla 1 Protocolo

metodológico para el diseño, implementación y evaluación de programas de

formación |

||||||

|

Secuencia de tipos de

evaluación |

Referentes

metodológicos |

|||||

|

Objetivo |

Metodología |

Valoración |

||||

|

Antes |

Evaluación de

necesidades |

|

|

|

|

|

|

Evaluación

de objetivos |

|

|

|

|

|

|

|

Evaluación

del diseño |

|

|

|

|

|

|

|

Durante |

Evaluación

de la implementación |

|

|

|

|

|

|

Después |

Evaluación

de resultados |

|

|

|

|

|

La

aplicación del protocolo metodológico formaría parte del proceso de evaluación

de programas, imprescindible en toda organización que se dedique a la formación

continua (Hernández-Mendo, 2001). Su aplicación se ilustra en un proceso de

evaluación de NNFF, además de por una cuestión práctica de espacio, por

considerarse una etapa esencial para lograr la competitividad y eficiencia de

los servicios (De Diego, Fraile y Boada, 2004), encontrándose intrínsecamente

ligada a la participación y posterior satisfacción de los usuarios. Si bien

podría implementarse en el resto de etapas evaluativas.

Para

realizar la aplicación se utilizó el modelo teórico de Altschuld y Witkin

(2000), adaptado por Chacón, Lara

y Pérez-Gil (2002). Según este modelo, el proceso de evaluación de

necesidades se compone de tres etapas sucesivas: la pre-evaluación, la

evaluación principal y la post-evaluación. En la Tabla 2, se concreta este

modelo mediante el protocolo metodológico.

|

Tabla 2 Referentes metodológicos en evaluación de necesidades |

|||||

|

|

Referentes

metodológicos |

||||

|

Objetivo |

Metodología |

Valoración |

|||

|

Participantes |

Instrumento/s |

Procedimiento |

|||

|

Pre-evaluación |

Determinar información

preexistente sobre necesidades. Identificar áreas de

mayor necesidad. Fijar límites y

delimitar fuentes potenciales de recogida de más información. |

Unidades a partir de

las cuales detectar necesidades preexistentes. |

Diversos instrumentos

en función del tipo de necesidades a analizar, del conocimiento previo

existente sobre ellas y del contexto organizacional. Es frecuente utilizar

instrumentos no estandarizados |

Recopilar necesidades

preexistentes. Organizar información

recopilada. Elaborar informe

técnico. Planificar siguiente

fase. Especificar criterios

preliminares para analizar la evaluación de necesidades al final del proceso. |

Describir de forma

preliminar las necesidades preexistentes. |

|

Evaluación principal |

Realizar la recogida principal de datos

(necesidades actualmente existentes). |

Unidades a partir de las cuales detectar necesidades existentes. |

Diversos instrumentos

en función del tipo de necesidades a analizar, del conocimiento previo existente sobre ellas y del contexto

organizacional. Es frecuente utilizar

instrumentos no estandarizados |

Administrar instrumentos seleccionados. Recoger y analizar los datos acerca de necesidades

existentes. Elaborar informe técnico. Planificar siguiente fase. Establecer prioridades preliminares para la

valoración final de necesidades. |

Describir, de forma

preliminar, las necesidades existentes. |

|

Post-evaluación |

Priorizar necesidades. Conectar datos

recogidos previamente con planes de acción a determinar e implementar. |

Unidades procedentes

de fases previas. Es posible la

participación de otros implicados relevantes. |

Instrumentos

suficientemente objetivos como para priorizar necesidades detectadas evitando

manejar criterios de conveniencia. |

Delimitar prioridades

finales y criterios para tomar decisiones. Ponderar alternativas para

subsanar necesidades más prioritarias. Formular planes de

acción (considerando recursos asignados). Elaborar informe

técnico. |

Valorar necesidades en

función de criterios de priorización previamente delimitados. Valorar el proceso y

resultados de la evaluación de necesidades. |

A

continuación, se describe la aplicación del protocolo en la evaluación de

necesidades llevado a cabo en el año 2006 para el diseño del Programa de Formación

2007, en el Departamento de Formación Continua de una organización andaluza de

referencia en el ámbito deportivo, dedicada al fomento de la formación

deportiva, la investigación, el estudio, documentación y difusión de las

Ciencias de la Actividad Física y del Deporte; y en materia de enseñanzas

náutico-deportivas (Chacón, Sánchez-Martín, Sanduvete y Holgado, 2007).

MÉTODOS

1. ETAPA 1: Pre-evaluación

1.1. Objetivo

Determinar

la información preexistente sobre NNFF en la organización, en este caso, las

necesidades detectadas en el transcurso del Programa de Formación previo (año

2005); identificar áreas con más NNFF; y delimitar potenciales fuentes de

recogida de más tipos y volumen de información.

1.2. Método

1.2.1. Participantes. Conformaron la

muestra 355 asistentes a acciones formativas (AAFF) del Programa de Formación

previo. Se caracterizaban por formar parte del sistema deportivo andaluz

pudiendo ser, por ejemplo, licenciados en Ciencias de

1.2.2. Instrumentos. Cuestionario de

satisfacción. Los datos fueron obtenidos a partir de un ítem

abierto de dicho cuestionario, concretamente del

ítem 14 Plantee

otras AAFF en las que le gustaría participar para mejorar el desarrollo de su

trabajo (Chacón, Gómez, Sánchez-Martín y Sanduvete, 2006).

1.2.3. Procedimiento. El equipo técnico

recopiló 149 NNFF diferentes que incluían, tanto a aquellas solicitadas en el

ítem 14 de los cuestionarios de satisfacción administrados en las AAFF

implementadas durante el Programa de Formación 2005, como a otras 5 AAFF

planificadas en dicho Programa pero no implementadas. La dirección de la

organización y el equipo técnico agruparon dichas AAFF en función de la

temática en seis áreas de conocimiento establecidas por la dirección (Gestión y

Administración Deportiva, Medicina Deportiva, Infraestructura Deportiva,

Turismo Deportivo, Actividad Física y Deportiva, y Formación de Formadores).

Posteriormente, el equipo técnico recogió el procedimiento seguido y los

resultados obtenidos en un informe. Finalmente, se planificó la siguiente fase

(entre otras tareas, el equipo técnico elaboró el cuestionario que se

utilizaría en la siguiente fase de evaluación principal) y tanto dirección como

equipo técnico acordaron los criterios preliminares para analizar la evaluación

de necesidades al final del proceso.

1.3. Valoración

Se

realizó una descripción de todas las AAFF demandadas por los participantes en

el Programa de Formación previo, junto con las AAFF no implementadas.

2. ETAPA 2: Evaluación principal

2.1. Objetivo

Recoger

las NNFF existentes en la organización durante el desarrollo del Programa de

Formación que se estaba implementando (año 2006).

2.2. Método

2.2.1. Participantes. Conformaron la muestra,

por una parte, 36 agentes deportivos de

2.2.2. Instrumentos. I. Cuestionario de

evaluación de NNFF, en el que se preguntaba por la denominación de la NF

propuesta, su grado de necesidad (de 1 a 5), la modalidad (presencial, a

distancia, tele-formación u otra), la utilidad/mejora en su puesto de trabajo,

los destinatarios o colectivo/s con la necesidad y el proponente (puesto de

trabajo e institución, entidad o administración en la que trabaja); II. Cuestionario

de satisfacción. Los datos se

obtuvieron a partir del ítem 14 Plantee otras NNFF que le gustaría satisfacer para

mejorar el desarrollo de su trabajo.

2.2.3. Procedimiento. El equipo técnico envió

a 172 agentes deportivos andaluces un correo electrónico que incluía el

cuestionario de detección de NNFF, solicitando su cumplimentación y reenvío.

Paralelamente, se fueron recopilando las NNFF expresadas voluntariamente por

los participantes en el cuestionario de satisfacción. Transcurrido el periodo

de tiempo establecido, se recogieron 153 NNFF, que fueron agrupadas por

dirección y equipo técnico en las áreas de conocimiento comentadas.

Posteriormente, el equipo técnico recogió el procedimiento desarrollado y los

resultados obtenidos en un informe. Asimismo, se planificó la siguiente fase;

entre otras tareas, el equipo técnico elaboró el cuestionario de priorización

de NNFF, y se establecieron las prioridades preliminares para la valoración

final de necesidades.

2.3. Valoración

Al

igual que en la fase anterior, se describieron las NNFF, en este caso

demandadas por los participantes en el Programa de Formación 2006 y agentes

deportivos.

3. ETAPA 3: Post-evaluación

3.1. Objetivo

Priorizar

las NNFF detectadas en las fases previas, y conectar las NNFF de los implicados

con el diseño del Programa de Formación 2007.

3.2. Método

3.2.1. Participantes. Conformaron la muestra

31 agentes deportivos de entre los mismos 172 que tuvieron oportunidad de

participar en la fase de evaluación principal. El tratamiento de la información

recogida también se realizó anónimamente.

3.2.2. Instrumentos. Cuestionario de

priorización de NNFF. En él se listaron las 302 NNFF

registradas en las fases anteriores, categorizadas en las áreas de conocimiento

citadas, y se preguntó a los participantes por el orden de priorización de

3.2.3. Procedimiento. El equipo técnico envió

por correo electrónico el cuestionario de priorización a los mismos agentes

deportivos que se tuvieron en cuenta en la fase anterior. Los participantes

debían priorizar un máximo de 10 NNFF de la/s área/s de conocimiento en la/s

que estuviesen interesados; en base a esta información se tomaría la decisión

de qué NNFF atender en el Programa de Formación 2007. Una vez recopilados los

cuestionarios cumplimentados, se codificaron y, en base al método de

escalamiento de Dunn-Ranking (Sanduvete et al., 2009), el equipo técnico obtuvo

el listado de necesidades priorizadas y elaboró un informe en el que se

recogieron el procedimiento seguido y los resultados obtenidos.

3.3. Valoración

Tras

una valoración global del proceso y los resultados obtenidos, la dirección y el

equipo técnico constataron que, de entre los cursos priorizados, 106 presentaban el mismo orden de priorización

que otro, aunque esto no afectó negativamente a la toma de decisiones final, y

el plan se conformó siguiendo fielmente estos resultados. El criterio de

inclusión/exclusión para formar parte del Programa de Formación 2007 fue, una

vez aplicado el método de Dunn-Ranking, estar en una posición por encima del

punto de corte relativo para cada área de conocimiento. Concretamente, la

proporción de AAFF a ofertar por áreas de conocimiento se obtuvo a partir de la

frecuencia relativa de NNFF propuestas y priorizadas por áreas, hasta llegar al

límite establecido por la dirección de 60 AAFF que, como máximo aproximativo,

podían conformar el Programa de Formación con los recursos disponibles.

En

base a los informes técnicos elaborados a lo largo del proceso, se publicaron

dos libros incluidos dentro de la colección de la organización (Chacón et al.,

2007), que pasaron a formar parte de la biblioteca de la organización, fueron

enviados a los agentes potenciales participantes, y fueron comentados y

discutidos en un encuentro sobre formación.

4. MEDICIÓN DE LOS REFERENTES

Una

vez detallados los objetivos, metodología y sistema de valoración utilizado en

cada fase, con ayuda de la aplicación del protocolo metodológico, se pudieron

medir, de forma sencilla, los referentes. Para la medición de los referentes participación, utilidad y transparencia,

en

|

Tabla 3 Indicadores para la medición de los referentes |

|

|

Especificación |

Indicadores |

|

-

Medición de acciones -

Si las acciones favorecieron la respuesta de los potenciales usuarios |

P1. Nº de

acciones concretadas y ejecutadas por dirección |

|

P2. Nº de

acciones concretadas y ejecutadas por equipo técnico |

|

|

P3. Nº de

datos recogidos |

|

|

-

Si se recogió de los implicados información completa para la posterior toma

de decisiones -

Si la información fue suficientemente precisa para facilitar la toma de

decisiones -

Si la propuesta final coincidió con los datos obtenidos |

U1. Nº de

instrumentos utilizados |

|

U2. Grado de

precisión en los resultados (nº de empates) |

|

|

U3. Grado de ajuste

entre los resultados obtenidos y la propuesta definitiva (% de acuerdo) |

|

|

-

Si se potenció una política de igualdad -

Grado de difusión de información relevante |

T1. Nº de

grupos implicados |

|

T2. Nº de

publicaciones sobre proceso y resultados |

|

|

T3. Nº de

estrategias de difusión de proceso y resultados |

|

|

P:

participación; U: utilidad; T: transparencia |

|

RESULTADOS

En

Tabla 4 Cuantificación de los indicadores para la medición de los referentes,

en evaluación de necesidades 2005 y 2006 |

||

|

INDICADOR |

2005 |

2006 |

|

P1. Nº de acciones concretadas y ejecutadas por dirección P2. Nº de acciones concretadas y ejecutadas por equipo

técnico P3. Nº de datos recogidos |

4 9 217+5 |

7 14 302+31 |

|

U1. Nº de instrumentos utilizados U2. Grado de precisión en los resultados (nº de empates) U3. Grado de ajuste entre los resultados obtenidos y la

propuesta definitiva (% de acuerdo) |

2 121 85 |

4 106 100 |

|

T1. Nº de grupos implicados T2. Nº de publicaciones sobre proceso y resultados T3. Nº de estrategias de difusión de proceso y resultados |

9 3 2 |

15 2 3 |

|

P: participación; U:

utilidad; T: transparencia |

||

Se

aprecia una mejora en prácticamente todos los indicadores medidos: 1. En relación

a la participación: (P1 y P2) se

aumentó el número de acciones concretadas y ejecutadas; (P3) En 2005 se

recogieron 217 datos en la pre-evaluación y evaluación principal, y 5

priorizaciones en la post-evaluación, mientras que en 2006 se recogieron 149

NNFF en la pre-evaluación, 153 en la evaluación principal (302 en total) y 31

priorizaciones. 2. Respecto a la utilidad:

(U1) En 2005, se recogió información con dos cuestionarios (uno común en

pre-evaluación y evaluación principal; y uno diferente en post-evaluación)

mientras que, en 2006, se utilizaron cuatro (uno en pre-evaluación, dos en

evaluación principal y uno en post-evaluación); (U2) El número de empates en la

priorización final pasó de 121 en

DISCUSIÓN

Y CONCLUSIONES

Los

cambios detectados resultaron indicativos de que la aplicación del protocolo facilitó

la especificación y mejora de los referentes participación, utilidad y

transparencia. El motivo nos parece

claro: cuando los procesos se especifican y se hacen visibles, se pueden

observar con mayor lucidez problemáticas latentes y las organizaciones se

esfuerzan aún más en minimizarlas o solventarlas. La consecuencia: el entorno

cambia en organizaciones de formación continua para hacerse más adecuado a la

hora de aplicar con éxito un MGC y minimizar los desajustes que suelen

producirse en su implementación; concretamente: 1. Se equilibró el esfuerzo y

tiempo dedicados a tareas de gestión de la calidad con las mejoras obtenidas,

ya que: I. Aumentó el grado de implicación y la participación, reflejado en el aumento tanto del número de tareas

concretadas que ejecutaron dirección y equipo técnico (coherentes con las que

llevar a cabo al aplicar un MGC), como de las respuestas en los participantes;

II. Aumentó la utilidad de los

resultados obtenidos con las acciones desempeñadas, al recogerse información

más variada, precisa, y acorde con la propuesta final. 2. Se potenció la

calidad de la formación y la satisfacción de los usuarios, ya que el programa

elaborado se ajustó en gran medida a las necesidades reales de los empleados:

I. El alto grado de participación

favoreció una recogida de información más exhaustiva; II. La variedad y

precisión de la información recopilada posibilitó el aumento de su utilidad, ajustándose el producto final

en gran medida a dicha información. 3. Se favoreció la adaptación de los MGC a

la organización, ya que se concretaron los objetivos a cumplir y las acciones a

realizar; y se fomentó la comunicación horizontal entre empleados por: I.

Aumento de la utilidad, al ajustarse

el programa a lo solicitado por los participantes. II. Aumento de transparencia, con la participación de

diferentes grupos de implicados, y la difusión y puesta al alcance de cualquier

interesado de la información sobre procedimiento y resultados.

La

utilidad de este instrumento se ha hecho visible a través de unas buenas

prácticas sobre evaluación de necesidades, proceso que no suele llevarse a cabo

y que implica, entre otros aspectos, la participación activa de los usuarios.

Según Liao et al. (2010b) los factores de gestión de la calidad en educación

superior y formación continua serían el enfoque en el cliente, la participación

de los trabajadores y equipo de trabajo, la mejora continua, el reconocimiento

y recompensa, la educación y formación, y el liderazgo. En este sentido, a

través del proceso analizado, se deja constancia de la orientación y el trabajo

focalizado que se ha llevado a cabo sobre la mayoría de los factores implicados

en la gestión de la calidad en el ámbito educativo. Así, sería necesario

asegurar la implicación del equipo directivo en los aspectos de reconocimiento

y recompensa y liderazgo, que también resultan esenciales para la adecuada

implementación de los MGC (Becket y Brookes, 2008).

Este

trabajo también se encuentra en consonancia con la principal línea de

investigación reciente dentro del área de la gestión deportiva, la cual tiene

como objetivo básico diseñar medidas específicas de la calidad del servicio

(Morales, Hernández-Mendo y Blanco, 2009) y de la satisfacción del cliente

(Nuviala, Tamayo, Fernández, Pérez-Turpin y Nuviala, 2011).

En

este artículo se ha intentado demostrar la utilidad del protocolo metodológico

como estrategia integral dentro del proceso evaluativo en organizaciones

dedicadas a la formación continua, para promover sinergias que minimicen los

desajustes al implementar un MGC en estos contextos. Se considera una

herramienta útil y apropiada para épocas de crisis, ya que maximiza los propios

recursos organizacionales; además, es de fácil aplicación y coherente con

cualquier otro instrumento que desee utilizarse. Para su uso, se aconseja

aplicar el protocolo en la situación actual de la organización en la fase

evaluativa deseada, y desde ahí delimitar los objetivos a conseguir,

especificándolos nuevamente a través del protocolo.

Cabe

señalar que el protocolo metodológico se aplicó eficazmente en otras dos

organizaciones dedicadas a la formación continua, una de las cuales ya fue

acreditada tras implantar un reconocido MGC.

REFERENCIAS

BIBLIOGRÁFICAS

Abdi, S. N. A., Awan, H. M. y

Bhatti, M. (2008). Is quality management a prime requisite for globalization?

Some facts from the sports industry. Quality

& Quantity, 42(6), 821-833. http://dx.doi.org/10.1007/s11135-007-9135-x

Alemna, A. A.

(2001). Perception of continuing education for librarianship in Ghana. New Library World, 102(1), 44-48.

http://dx.doi.org/10.1108/03074800110365480

Altschuld, J. W. y Witkin,

B. R. (2000). From needs assessment to action.

Transforming needs into solution strategies.

Thousand Oaks, CA: Sage.

Amo, C. y

Cousins, J. B. (2007). Going through the process: an examination of the

operationalization of process use in empirical research on evaluation. New Directions for Evaluation, 116,

5-26. http://dx.doi.org/10.1002/ev.240

Andrés, M. A.

(2005). Propuesta

de indicadores del proceso de enseñanza/aprendizaje en la formación profesional

en un contexto de gestión de calidad total. Revista

ELectrónica de Investigación y EValuación Educativa, 11(1). Disponible en

http://www.uv.es/relieve/v11n1/RELIEVEv11n1_4.htm.

Anguera, M. T., Chacón, S. y Sánchez-Martín, M.

(2008). Bases metodológicas en evaluación de programas. En M. T. Anguera, S.

Chacón y A. Blanco (Coords.), Evaluación de programas sociales y sanitarios:

un abordaje metodológico (pp. 37-68). Madrid, España: Síntesis.

Aragón, L. (2004). La gestión de calidad en

educación. Educar en el 2000, 8, 21-30.

Disponible en https://www.educarm.es/documents/246424/461838/revista8_03.pdf

Asif, M., Awan, M. S., Khan, M. K. y Ahmad, N.

(2011). A model for total quality management in higher

education. Quality & Quantity, 47(4),

1883-1904. http://dx.doi.org/10.1007/s11135-011-9632-9

Becket, N. y

Brookes, M. (2008). Quality management practice in higher education –what

quality are we actually enhancing? Journal

of Hospitality, Leisure, Sport and Tourism Education, 7(1), 40-54.

http://dx.doi.org/10.3794/johlste.71.174

Boyer,

C. (2003). Calidad total y formación continua. Razones para una posición

crítica. En VV.AA., Calidad y formación: binomio inseparable (pp.

137-143). Madrid, España: Instituto Nacional de Empleo.

Calabuig,

F., Burillo, P., Crespo, J., Mundina, J. J. y Gallardo, L. (2010).

Satisfacción, calidad y valor percibido en espectadores de atletismo. Revista Internacional de Medicina y Ciencias

de la Actividad Física y el Deporte, 10(40), 577-593. Disponible en http://cdeporte.rediris.es/revista/revista40/artsatisfaccion182.htm

Chacón,

S., Anguera, M. T., Pérez-Gil, J. A. y Holgado, F. P. (2002). A mutual catalytic model of formative evaluation. The interdependent

roles of evaluators and local program practitioners. Evaluation, 8(4), 413-432.

http://dx.doi.org/10.1177/13563890260620612

Chacón,

S., Gómez, N., Sánchez-Martín, M. y Sanduvete, S. (2006). Formación en el

Instituto Andaluz del Deporte. Evaluación y diseño. Vol. 1-4. Málaga,

España: Instituto Andaluz del Deporte (Consejería de Turismo, Comercio y

Deporte).

Chacón, S., Lara, A. y Pérez-Gil, J. A. (2002). Needs assessment. En R. Fernández-Ballesteros (Ed.), Encyclopedia of

Psychological Assessment (Vol. 2, pp. 615-619). Londres, Inglaterra:

Sage.

Chacón,

S., Sánchez-Martín, M., Sanduvete, S. y Holgado, F. P. (2007). Formación en

el Instituto Andaluz del Deporte. Evaluación y diseño. Vol. 1-4. Málaga,

España: Instituto Andaluz del Deporte (Consejería de Turismo, Comercio y

Deporte).

Chacón,

S., Sanduvete, S., Portell, M. y Anguera, M. T. (2013). Reporting a program evaluation: Needs, program plan, intervention, and

decisions. International Journal of

Clinical and Health Psychology, 13(1), 58-66. http://dx.doi.org/10.1016/S1697-2600(13)70008-5

Consejería

de Justicia y Administración Pública de

Cruickshank, M. (2003). Total quality management in

the higher education sector: a literature review from an international and

Australian perspective. TQM and Business

Excellence, 14(10), 1159-1167.

http://dx.doi.org/10.1080/1478336032000107717

De Diego, R., Fraile, A. y Boada, J. (2004). Training needs

among sport technicians. Psicothema, 16(1), 84-87. Disponible en

http://www.psicothema.com/pdf/1165.pdf

Dickerson, P. (2000). A CQI approach to evaluating

continuing education: processes and outcomes. Journal for Nurses in Staff

Development, 16(1), 34-40.

http://dx.doi.org/10.1097/00124645-200001000-00007

Domínguez,

G. y Lozano, L. (2005). La calidad, más que una moda, un reto en

Ehlers, U.-D., Hildebrandt, B., Görtz, L. y Pawlowski, J. M. (2005). Use

and distribution of quality approaches in European e-learning. Thessaloniki,

Grecia: CEDEFOP.

Fetterman,

D. y Wandersman, A. (2007). Empowerment evaluation: yesterday, today, and

tomorrow. American Journal of Evaluation, 28(2), 179-198. http://dx.doi.org/10.1177/1098214007301350

Hernández-Mendo, A. (2001).

Un cuestionario para evaluar

la calidad en

programas de actividad

física. Revista de Psicología del

Deporte, 10, 179-196. Disponible en www.rpd-online.com/article/download/164/164

Kasperavičiut, R. (2011). Application

of the European foundation for quality management excellence model in higher

education institutions. Public Policy and Administration, 10(3), 387-402. http://dx.doi.org/10.5755/j01.ppaa.10.3.639

Liao, S.-H., Chang, W.-J. y Wu, C.-C. (2010a).

Exploring TQM-Innovation relationship in continuing education: a system

architecture and propositions. Total

Quality Management & Business Excellence, 21(11), 1121-1139.

http://dx.doi.org/10.1080/14783363.2010.529330

Liao, S.-H., Chang, W.-J. y Wu, C.-C. (2010b).

An integrated model for learning organization with strategic view: benchmarking

in the knowledge-intensive industry. Expert

Systems with Applications, 37, 3792–3798.

http://dx.doi.org/10.1016/j.eswa.2009.11.041

Martínez, J.

A. y Martínez, L. (2009). Percepción del empleado y del cliente en servicios

públicos deportivos. Revista

Internacional de Medicina y Ciencias de la Actividad Física y el Deporte, 9(34),

158-178. Disponible

en http://cdeporte.rediris.es/revista/revista34/artpercepcion113.htm

Morales, V., Hernández-Mendo, A. y

Blanco, A. (2009). Evaluating quality in sports organisations: an

adaptation of the SERVQUAL model. Revista de Psicología del Deporte,

18(2),

137-150. Disponible en www.rpd-online.com/article/download/301/296

Nuviala, A., Tamayo, J. A., Fernández, A., Pérez-Turpin, J. A. y Nuviala

R. (2011). Calidad del servicio deportivo en la edad escolar desde una doble

perspectiva. Revista Internacional de

Medicina y Ciencias de la Actividad Física y el Deporte, 11(42), 220-235.

Disponible

en http://cdeporte.rediris.es/revista/revista42/artcalidad210.htm

Pawlowski, J. M.

(2007). The quality adaptation model: adaptation and adoption

of the Quality Standard ISO/IEC 19796-1 for learning, education, and training. Educational Technology & Society, 10(2),

3-16. Disponible en http://www.ifets.info/journals/10_2/2.pdf

Petridou, E. y

Chatzipanagiotou, P. (2004). The planning process in

managing organisations of continuing education: the case of Greek vocational training

institutions. The International Journal

of Educational Management, 18(4), 215-223.

http://dx.doi.org/10.1108/09513540410538804

Regnier, K., Kopelow, M., Lane, D. y Alden, E. (2005).

Accreditation for learning and change: quality and improvement as the outcome. The Journal

of Continuing Education

in the Health

Professions, 25, 174-182. http://dx.doi.org/10.1002/chp.26

Sakthivel,

P. B. y Raju, R. (2006). Conceptualizing total quality management in engineering education and

developing a TQM educational excellence model. Total Quality Management, 17(7), 913–934.

http://dx.doi.org/10.1080/14783360600595476

Sanduvete, S., Barbero, M. I., Chacón, S., Pérez-Gil,

J. A., Holgado, F. P., Sánchez-Martín, M. y Lozano, J. A. (2009). Métodos de escalamiento

aplicados a la priorización de necesidades de formación en organizaciones. Psicothema, 21(4), 509-514. Disponible en

http://www.psicothema.com/pdf/3662.pdf

Sirvanci,

M. B. (2004). Critical issues for TQM implementation in higher

education. The TQM Magazine, 16(6),

382-386. http://dx.doi.org/10.1108/09544780410563293

Srikanthan, G. y Dalrymple, J. (2004). A synthesis of a quality management

model for education in universities. International

Journal of Educational Management, 18(4), 266-279. http://dx.doi.org/10.1108/09513540410538859

Van den Berghe, W. (1998). Aplicación de las

Normas ISO

Vedung,

E. (1996). Utilización de la evaluación de programas. En R.

Fernández-Ballesteros (Ed.), Evaluación de programas. Una guía práctica en

ámbitos sociales, educativos y de salud (pp. 321-338). Madrid, España: Síntesis.

Weiss, C. H. (1979). The many meanings of research

utilization. Public Administration

Review, 39(5), 426-431. http://dx.doi.org/10.2307/3109916

Número de citas totales / Total references: 40 (100%)

Número de citas propias de la

revista / Journal's own references: 3 (7,5%)

Rev.int.med.cienc.act.fís.deporte

- vol.15 - número 60 - ISSN: 1577-0354